Cada vez mais, na América Latina e no Caribe (ALC) utiliza a inteligência artificial (IA) na tomada de decisões cotidianas que afetam milhões de pessoas: processos de seleção de bolsas de estudo, subsídios, alertas de serviços sociais, identificação biométrica e inclusive a orientação a vítimas de violência.

Mas, como adverte o Relatório Regional sobre Desenvolvimento Humano 2025, a IA se consolida em uma região com desigualdades persistentes, e os dados que alimentam esses sistemas refletem inevitavelmente os vieses arraigados na sociedade. Se os algoritmos aprendem com essas realidades, o viés de gênero deixa de ser uma falha de laboratório e se torna um problema de desenvolvimento: pode excluir quem menos aparece nos registros — como mulheres pobres, indígenas, migrantes ou rurais — o que corroeria ainda mais a confiança institucional.

Mas a mesma tecnologia que pode aprofundar as desigualdades também serve para proteger, informar e abrir oportunidades, em especial para grupos tradicionalmente excluídos. O desafio é reduzir esse viés e apostar em controles verificáveis que priorizem a equidade para ampliar direitos, melhorar o foco das políticas e fortalecer um crescimento mais inclusivo.

Um problema “técnico” que já é de desenvolvimento

Um dos principais usos da inteligência artificial baseia-se em identificar padrões em grandes volumes de dados para otimizar decisões. No entanto, os modelos que “calculam a média” de populações diversas podem desfavorecer grupos sub-representados e reproduzir padrões históricos de discriminação. Em programas de proteção social, por exemplo, vários países da ALC incorporaram modelos automatizados para classificar pessoas e atribuir benefícios, mas os sistemas de pontuação podem perpetuar a exclusão se alimentados com dados onde as mulheres ou outros grupos não estão equitativamente representados.

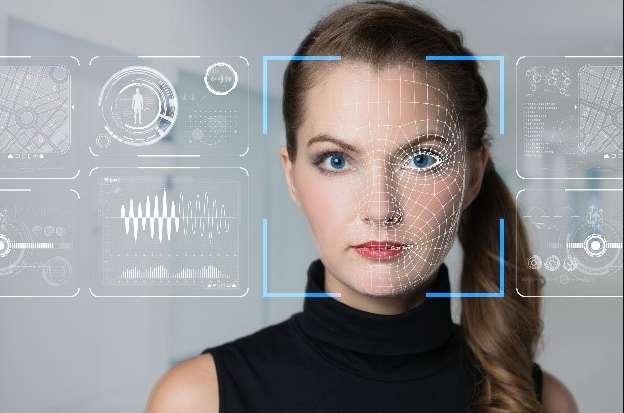

O viés de gênero aparece em decisões concretas, e a segurança pública oferece um contraponto igualmente ilustrativo. A região adotou rapidamente tecnologias biométricas e de reconhecimento facial, mas estudos mostram que os falsos positivos pesam mais sobre as mulheres, e em particular sobre as mulheres racializadas. Esses erros de identificação comprometem liberdades, podem levar a detenções injustas e amplificar desigualdades.

Paralelamente, quando os algoritmos de contratação replicam históricos laborais masculinizados ou quando o crédito é concedido com modelos que penalizam as trajetórias femininas segundo os critérios do sistema bancário tradicional, reduzem-se as oportunidades para as mulheres, perde-se a produtividade e limita-se o empreendedorismo. A região não pode se permitir adotar tecnologias que excluam o talento feminino de mercados já segmentados.

Investir em dados representativos e fortalecer os marcos regulatórios do uso da IA, incorporando métricas de equidade e mecanismos de prestação de contas, são passos essenciais para usar essa tecnologia de forma responsável e inclusiva. Assim, a inteligência artificial pode se tornar uma oportunidade não só para melhorar a eficiência na tomada de decisões, mas também para ampliar a base de beneficiárias da inovação, acelerar a adoção digital e promover a inclusão laboral e financeira.

Também convém revisar o plano simbólico: a feminização por padrão de assistentes virtuais ou chatbots — através de seus nomes, vozes e avatares — reproduz hierarquias. Isso pode ser justificado em serviços específicos, mas, como norma, reforça estereótipos sobre o papel das mulheres na sociedade. O design de interfaces, cada vez mais usado para melhorar a prestação de serviços públicos, também é um elemento de política pública.

Liderança feminina: de “outliers” a designers

Os princípios de não discriminação, transparência e supervisão humana já figuram entre as estratégias e marcos de vários países da região. O desafio é traduzi-los em controles verificáveis: documentar a composição demográfica dos dados; avaliar o desempenho por subgrupos (mulheres por idade, origem, condição migratória ou ruralidade); monitorar os resultados após a implantação dos sistemas; e exigir auditorias independentes obrigatórias em sistemas de alto impacto (como aqueles usados para proteção social, saúde, justiça e segurança). Com esses controles, a IA se torna auditável e governável.

Devido a exclusões históricas e baixa visibilidade em dados formais, os sistemas tendem a classificar as mulheres como “outliers”, um termo que em estatística define um valor atípico, ou seja, uma observação que é numericamente distante do resto dos dados. A partir de um enfoque estritamente estatístico, os resultados de conjuntos de dados com valores atípicos podem levar a conclusões erradas, por isso geralmente são evitados. No entanto, isso nem sempre se aplica a contextos mais sutis, como solicitações de crédito, vagas de emprego ou programas sociais, onde as características das mulheres podem diferir das dos homens, mas não devem ser motivo para exclusão de processos seletivos.

Mas as mulheres na região não são só usuárias de IA, mas também líderes na criação de soluções: marcos feministas para o desenvolvimento de IA, ferramentas abertas para detectar estereótipos em modelos de linguagem e iniciativas que incorporam uma perspectiva de gênero no trabalho em plataformas. Colocar as mulheres no centro — como designers, auditoras, reguladoras e usuárias — melhora a qualidade técnica dos sistemas e acelera sua aceitação social. Esta também é uma política de inovação.

Em última análise, a redução do viés de gênero multiplica os retornos: políticas sociais mais precisas e legítimas; segurança compatível com direitos; mercados de trabalho e financeiros mais inclusivos e produtivos; e maior confiança em instituições capazes de governar tecnologias complexas. Isso se traduz em desenvolvimento humano: mais capacidades reais — saúde, educação, participação, trabalho decente — e mais agência para impactar a própria vida e o entorno.

A IA não é neutra, mas pode ser justa. Para atingir esse objetivo, a América Latina e o Caribe precisam adotar um padrão mínimo já ao seu alcance: dados representativos e documentados, métricas de equidade para subgrupos, auditorias independentes e vias de reparação quando há danos. Reduzir o viés de gênero não só abre oportunidades para as mulheres, mas também impulsiona o desenvolvimento de toda a região.

Este artigo baseia-se nas conclusões do Relatório Regional de Desenvolvimento Humano de 2025, intitulado “Sob Pressão: Recalibrando o Futuro do Desenvolvimento”, elaborado pelo Programa das Nações Unidas para o Desenvolvimento (PNUD) na América Latina e no Caribe.

Tradução automática revisada por Isabel Lima